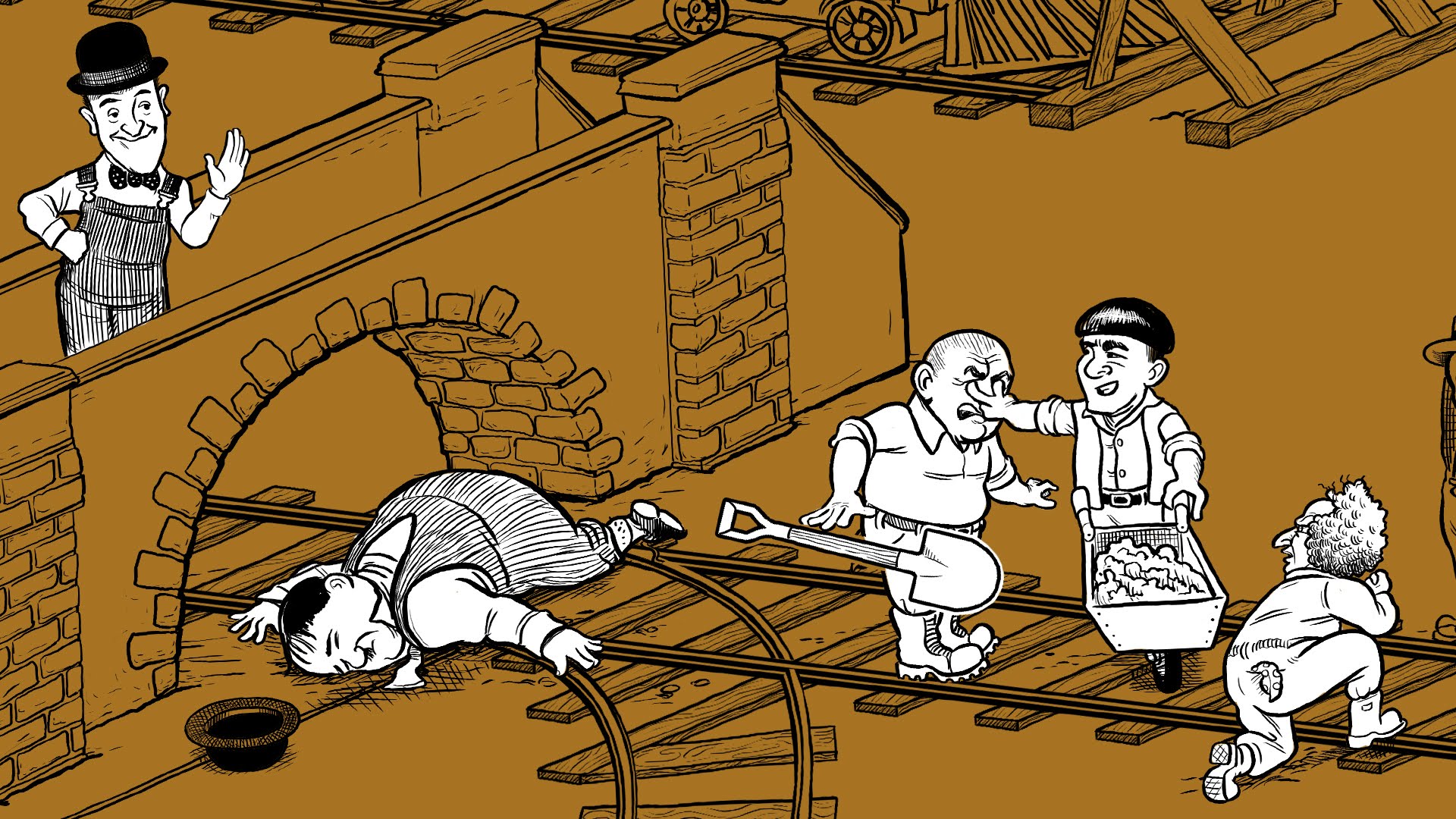

Arizona’da meydana gelen ve ölümle sonuçlanan bir sürücüsüz otomobil kazası, 1970’lerde popüler olan hikayeyi tekrar gündeme getirdi. Adalet üzerine fikirlerinden tanıdığımız Harvard profesörlerinden Michael Sandel tarafından da halen anlatılmakta olan bir örneği. Örneğin zaman içinde diğer varyantları da geliştirilmişti; tramvayın geçeği demiryolunun üzerindeki köprüde bir şişko (sıfat bize ait değidir) boş boş bakınmaktadır . Onu köprüden atarsanız, hiçbir sağlıklı işçinin ölmesine gerek kalmayacaktır, bu durumda seçiminiz nasıl olur? Peki köprünün üzerindeki Marilyn Monroe ise ve siz onun rüzgarda saçılan eteklerini seyretmekte iseniz hangi seçimi yapacaksınız? Peki ya diğer hattaki işçi oğlunuz ise? Benzer bir konuyu faydacı yaklaşımların adalet amaçlı kullanılmasını eleştirdiğimiz, ve bir filikada mahsur kalmış kazazedelerin kendilerini kurtarmak için içlerindeki en zayıf olanı yedikleri Kraliçeye karşı Dudley Stephens davası üzerine yazdığımız yazıda da irdelemiştik.

Tramvay problemi ilk yıllarda psikolojik amaçlı kullanılan bir araç iken, son zamanlarda sürücüsüz araçların ahlaki açıdan sorgulanması amacı ile de gündeme getirilmekte. Bu problem o kadar gündeme oturdu ki, MIT mühendisleri, Ahlak Makinesi (Moral Machine) adını verdikleri kitlesel bir katalog merkezi oluşturarak, gelecekteki robotik araçların farklı şartlar altında nasıl davranmaları gerektiğine ilişkin fikirleri toplamaya başladılar bile. Yakınlarda The Atlantic.com'da yayınlanan makalede de konuyu irdelemeye çalışılmış.

Peki bu tramvay problemi günümüzün sürücüsüz araçları için uygun bir örnek teşkil ediyor mu? Yani mühendislik politikalarına rehberlik edecek bir kaynak olarak, makinelerin etiği için eksik ve tehlikeli çıkartımlara neden olmayacak mı?

1967 yılında felsefeci Philippa Foot, insanların niyetlendikleri ile öngörebildikleri arasındaki farkı irdeleyen, kürtaj üzerine bir senaryo yayınladı. Hamile bir kadının rahmini almak (histeroktomi) isteyen cerrah uterusu almayı hedeflese de, sonucunda bebeğin ölümünü öngörebilmektedir. Diğer taraftan, bir annenin hayatını kurtarmak için bir fetüsü alan doktor, bebeğin ölümünü başından hedeflemektedir. Benzer şartlar altında kimi zaman farklı ahlaki çıkartımlar yapılabilir. Foot, bir kişinin yapıp ettikleri ve yapılıp edilmesine izin verdikleri arasındaki farkın bu sonucu yarattığı düşüncesinde.

Bu durumda demiryolu makasın başında durup kararı verecek kişinin sorması gereken sorular ne olmalıdır?

– Olacaklara müdahale etme hakkım var mı? Nereden alıyorum bu hakkı?

– Müdahil olmamak beni sorumlu kılar mı?

– Müdahil olmanın doğuracağı sonuçları hesaplama yeteneğim var mıdır?

– Benim yaptıklarımın sonuçlarından etkilenecek kişilerin gelecekleri ile ilgili ne kadar hesaplama yapabilirim?

Makaleye dönersek, Foot’un önermesi, sürücüsüz otomobillerin ahlaki senaryolarını değerlendirme üzerine, tramvay probleminden biraz daha farklılaşmış bir yaklaşım sergiliyor. Sonuçta Foot, Aristo’nun erdem anlayışının bir takipçisi sayılabilir, diyor yazar. Ancak, sürücüsüz araç tartışmalarının odağında erdem yerine, çıktılara dayanan sonuçculuk (consequentialism) anlayışı var; yani bir tür Faydacı akım.

2016’da ABD’de trafik kazalarında hayatını kaybeden 37.000 kişi (Türkiye’de 7.300) dikkate alındığında, hele bu kazaların%94’ü sürücüden kaynaklanan hatalar nedeniyle oluştuğu düşünülürse, sürücüsüz araçların sağlayabileceği güvenlik getirisinin toplumsal açıdan göz ardı edilemeyeceği açık.

Yasal sorumluluk boyutunu şimdilik bir tarafa bırakırsak, çok yakın zamanda sürücüsüz araçların, hata yapma olasılığı daha yüksek insan kullanıcılara göre çok daha etkin bir çözüm olacağı su götürmez. Arizona’da ölümle sonuçlanan olay bir trajedi olsa da, binlerin ölümünün önüne geçecek gelişmelerin önünü tıkamamalı, makalenin yazarına göre.

Karar alma güçlükleri olsa da robotların olmadığı bir geleceği artık hayal etmek imkansız. Sadece faydacı yöntemle yapılabilecek nimet-külfet analizleri değil, ahlaki değerler açısından da robotların daha adil kararlar alabileceğini hayal edebiliriz şimdilik.

Isaac Asimov, gelecekteki hayatımızı robotlarla beraber ilk hayal etmeye başladığında (Vakıf dizisi) robotlar için üç asli programlama yasası ortaya koymuştu:

1. Bir robot, bir insana zarar veremez ya da zarar görmesine seyirci kalamaz.

2. Bir robot, birinci kuralla çelişmediği sürece bir insanın emirlerine uymak zorundadır.

3. Bir robot, birinci ve ikinci kuralla çelişmediği sürece kendi varlığını korumakla mükelleftir.

Zamanla bu yasaların robot davranış modellemesi için yeterli olmadığı anlaşılınca, bu üç yasanın üzerine Sıfırıncı (Zeroth) bir yasa daha eklemişti:

Bir robot insanlığa zarar veremez ya da zarar görmesine seyirci kalamaz.

Bu son yasa, hem yapıp etmeleri hem de yapıp etmelere seyirci kalma durumunu güvence altına almaktaydı ve ilk yasayı da şöyle elden geçirmek gerekmişti:

Bir robot, Zeroth yasasıyla çelişmediği sürece bir insana zarar veremez ya da zarar görmesine seyirci kalamaz.

Bu şekilde programlanmış bir robot, tramvay probleminde olasılıkla daha az kayıp olan seçeneği tercih edecektir. İkinci versiyonda büyük olasılıkla köprüden kendisini atarak, ne şişko adamın ne de Marilyn Monroe’nun ölmesine izin vermeyecektir.

Tramvay probleminin ilk versiyonunda elinde yeterli veri seti bulunan rasyonel bir insan da Asimov’un robotu gibi karar verebilir. Ancak, diğer rotada bulunan tek kişinin bu rasyonel insanın oğlu olduğunu düşünelim bir an. Rasyonel de olsa insan mı, yoksa robot mu daha adil davranabilir? Sorulması gereken soru budur.

Ne Atlantic.com'un makalesinde ne de Adam Sandel’in yaklaşımlarında, olası kurbanların sorumluluklarının irdelendiğini de görmedim. Yani tramvay probleminin ilk versiyonunda çalışan beş işçi, sonuçta bu işi kabul etmiş kişiler olarak olası risklerin farkında değiller midir? O zaman olası risklerle ilgili zımni bir sözleşme yapılmış varsayılamaz mı? Bu durumda, diğer hattaki tek kişinin de demiryolu işçisi ve sıradan vatandaş olması varsayımlarında alınması gereken karar aynı mı olacaktır? Yani olası riskler için ücret ödenen bir kişi ile, şans eseri oradan geçmekte olan vatandaşın durumu sorumluluk açısından aynı mıdır?

Bu konu daha çok su ve soru kaldıracaktır.

Ender Şenkaya

Nisan 2018

Kaynak: The Atlantic.com Trolley Problem